这不前阵子,马斯克扬言已将大脑上传到云端,并与虚拟版本进行交谈。

关于人造大脑这事儿,再次引发了热议:

人类是否能构建跟人脑一样的机器脑?

事实上这个问题,不光是理念,更已经是一种实践方向——归属于类脑计算的范畴。作为下一代人工智能的“种子选手”,它有望打破传统冯诺伊曼架构,*新的计算变革。

不过发展至今,类脑计算始终呈现出正负两极的评价。

一面是业内如火如荼的融资进展。据相关机构预测,2035年类脑计算的市场规模约200亿美元。另一面则是脑机制研究不深入、没法复刻出相仿的神经网络等质疑。

到底是口耳相传的噱头,还是实打实的硬科技突破?

借着这一契机来盘一盘类脑计算到底什么来头?

01

什么是类脑计算

与人工智能、机器学习类似,类脑计算目前没有明确的定义。以至于有关它的英文表达,也不止一种:

Brain-like Computing(仿脑计算);Brain-inspired Computing(脑启发计算);Neuromorphic Computing(神经形态计算)……

不过字面拆解来看,类脑计算就是借鉴生物大脑的信息处理机制,以此诞生的一种新型计算形态。

与现有计算机相比,生物大脑(以人脑代表)有诸多优势。中科院院士、浙大校长吴朝辉曾撰文,主要有以下几点:

功耗低,仅20瓦左右;

容错性强,即便少部分神经元死亡,对整体功能影响不大;

并行处理信息;

神经网络可塑性好,可根据环境变化自主学习和进化。

而以神经科学为导向、以大脑为模仿对象的类脑计算,既保留计算机本身优势,又叠加了大脑处理机制的buff,比如低功耗、自主决策学习、并行处理等特点,自然成为*新一代计算变革的种子选手。

近年来,人工智能,尤其是深度学习取得了令人瞩目的成果,在某些方面的表现甚至已经超越了人类。

但与自然智能相比,深度学习在效率、功耗以及通用性上仍有一定的局限性,远没有达到真正意义上的智能程度。

类脑计算另辟蹊径,于是就成为科学家们的研究重点。

但想要实现真正的类脑并非那么容易,即便上世纪末科学家们就已经开始探索。清华大学集成电路学院何虎教授将其形容为珠峰。谁也不清楚,哪一条路会攀上顶峰。

目前,类脑计算大体可分成三种探索方向:

![]()

模拟神经元结构和功能,简单来说就是仿真真实大脑机理,进而探索大脑内部的“运作模式”。

最新代表性进展来自北京智源人工智能研究院给出的“智能线虫”——天宝1.0。

它完整模拟出秀丽隐杆线虫的神经系统——302个神经元,以及数千个连接,并为它构造了3D流体仿真环境。它可以在其中蠕动前行,并具备简单趋利避害的能力。

不过这种逆向工程——从生物体环境提取出抽象的数字模型,存在一定的局限性。

一言以蔽之,就是生物大脑本身的复杂度。

正如何虎教授所介绍:一方面,大脑环境过于复杂。抽象出的大脑模型,相当于只是简化版。另一方面,结构和功能之间“有壁”。即便成功构建了大脑结构,距离真正实现其功能还有很长的路要走。

这一路径目前还停留在学研阶段,在此就不进一步深入展开。

核心来看剩下两种路径:模拟神经网络以及开发新型电子设备。更通俗来讲,即软件算法层面,或硬件芯片层面上对大脑机制的模拟。

为了便于理解,将类脑计算与当下主流的深度学习作为对比。

![]()

先来看软件算法层面,生物神经元是以脉冲的形式将信息传递到下一个神经元层,放在类脑计算的研究中,即演化为脉冲神经网络SNN。

SNN,相较于DNN,更忠实地模拟大脑神经元和连接电路,其信息载体为脉冲序列,有空间域和时间域两个维度来传递信息,在中科院李国齐教授看来,SNN兼具生物合理性与计算高效性。

进一步的,北京理工大学杨旭博士分享了类脑算法与传统算法模型之间的不同,核心有三个层面:

连接方式不同,稀疏连接与全连接;

驱动方式不同:事件驱动与数据驱动;

学习方式不同:DNN是从大量数据中总结出规律,而SNN则是因果学习,自适应能力强。

这也就导致SNN所表现出的功耗更低,效率更高以及自适应能力更强。

但与此同时,也不免有人质疑SNN的有效性。

因为关于SNN训练,目前还面临着诸多挑战,包括脉冲神经元中复杂的时空动力过程、脉冲信息不可导、脉冲退化和训练精度损失等,也就进一步导致当前尚未存在一种统一的、且公认有效的算法来训练它。

具体举个例子,如杨旭博士所说,比如由于SNN中的脉冲不可微分,DNN中非常成熟的梯度下降法就没法直接应用,但现在由于对大脑机制的理解还不够,就找不到一个能和该方法同样有效的训练方法。

处于同一境地的,还有类脑芯片。

目前也没有统一的技术方案(此处统一指代的是具有超低功耗的计算芯片)。

世界上最早的一款类脑芯片,当属于IBM于2011年研制出的两个具有感知认知能力的硅芯片原型。

随后像英特尔、斯坦福、曼大、浙大、清华也都相应推出自己的芯片方案。

![]()

2019年,第三代天机芯登上Nature封面,再度掀起对类脑芯片的热议。芯片搭载在无人驾驶自行车上,实现了自主决策、实时视觉探测、自动避障等功能。

除此之外,另外两种趋势也不容忽视。

一种是类脑感知芯片,也叫做神经形态传感器,即对类脑触觉、视觉、听觉等传感器的研究,开发具有高时间分辨率、低延时、低功耗的新型传感器,在机器人、物联网等方面有应用价值。

比如三星的动态视觉传感器(DVS),配在数码相机上就能捕捉2000帧的画面,只消耗300毫瓦的电能。

另一种则是材料的延伸,开发基于纳米等新材料的芯片,比如像忆阻器、相变存储器、电化学存储器。

可以感知到的是,兜兜转转近十年的类脑芯片,目前还市场标准还未统一,应用场景也多样。更多芯片方案还处于自我更新迭代当中。

算法如此,芯片如此,背后的核心原因其实也不难理解。

一方面是理论知识不够,受限于对大脑机制的了解;另一方面则是工程化难题,从理论落到实际。

也正因此,类脑计算相关的质疑始终不少。

甚至有人直言:噱头而已。

02

当前行业现状如何?

是不是真的噱头,且来看当前的行业现状。

事实上,我们已经可以见到类脑计算商业化的身影。放眼全球,从2013年开始便有相关创企开始冒头,国内则集中爆发于2017-2018年。

据不完全统计,全球类脑企业公司已有20家左右,虽然融资轮次多集中于A轮,但各家公司拿到的融资金额少则千万多则上亿,甚至还出现了一家上市企业,来自法国的Brainchip。

跟更多前沿产业一样,有几家是直接从相关大学或研究所的类脑研究成果中孵化而来,Brainchip在内包括Innatera、时识科技、灵汐科技、优智创芯等。

![]()

△ 国外类脑企业代表

![]()

△ 国内类脑企业代表

从这些公司的技术路线上来看,主要有两条路径,恰好也是前面提到实现类脑智能的两种解决思路。

一是芯片优先,即在硬件层面上进行对大脑机制的模拟。目前大多数类脑企业都是这个思路。

以优先上市的Brainchip为例,他们研发出了世界上*款商用神经拟态处理器Akida,面向边缘AI计算,去年10月开始量产。今年2月还与奔驰达成合作,用于座舱内的感知和识别。

最新融资约4000万元的荷兰企业Innatera,去年推出了一款基于SNN的神经拟态加速器,主要用于语音识别、生命体征监测和雷达等。

再比如专注于图像和视频领域的类脑企业PROPHESEE,通过模仿人眼和大脑的工作方式,开发出了一款类脑智能视觉处理器,能够帮助提高自动驾驶、工业自动化、物联网、安防以及AR/VR等领域的识别效率。

国内方面的代表,比如时识科技,其产品既包括可达到0.1mW的超低功耗计算芯片,还包括可用于面部检测、实时手势识别、实时目标分类等视觉任务的各类动态视觉类脑感知芯片。

做感知芯片的不算少,还包括专注类脑触觉芯片的他山科技(该芯片于去年9月流片),专注类脑嗅觉芯片的中科类脑(主要用于火灾预警等场景)等。

灵汐科技的重点是异构融合类脑计算芯片,该类芯片只需12W功耗即可提供32Tops的INT8算力和6Tflops的FP16算力。……

这种以芯片优先的思路,*好处是可以率先实现类脑的有效性,发挥它的低功耗优点。可以看到,目前这些产品已经大多落地于物联网、边缘计算等场景。

不过,这种思路也有它的局限性。我们知道,市面上的每一种产品实际上都是工程落地的问题。

但是在工程落地之前,要先把它最根本的物理原理理解清楚,变成算法,然后再去寻找最合适的工程方法,去做芯片,把它变成产品落地。

也就是说,芯片其实是为算法服务的。于是乎产业界出现了另一种声音:

如果连一个有效的算法都没有,相关的硬件和硬件加速又从何谈起呢?

这也恰好是*种技术路线:以算法优先,然后再以算法定义芯片。

事实上,这种方式并不陌生,早在人工智能浪潮开始时,就有一波AI公司走的这条路径,比如旷视、地平线、商汤等。

因为用“算法定义硬件”,往往可以实现芯片性能的*化。

像深度学习加速器,就是“算法定义硬件”的典型,当传统的芯片hold不住越来越快的新算法时,我们就通过优化算法来获得计算资源需求和内存需求更小的新模型,让芯片得以“适应”。

这种优势延伸到类脑领域,可以让开发出来的类脑算法运行在普通的芯片架构上,让传统芯片也能拥有此前不具备的能力。

因此,也有一些企业选择了这条路。

优智创芯,就是当前代表。

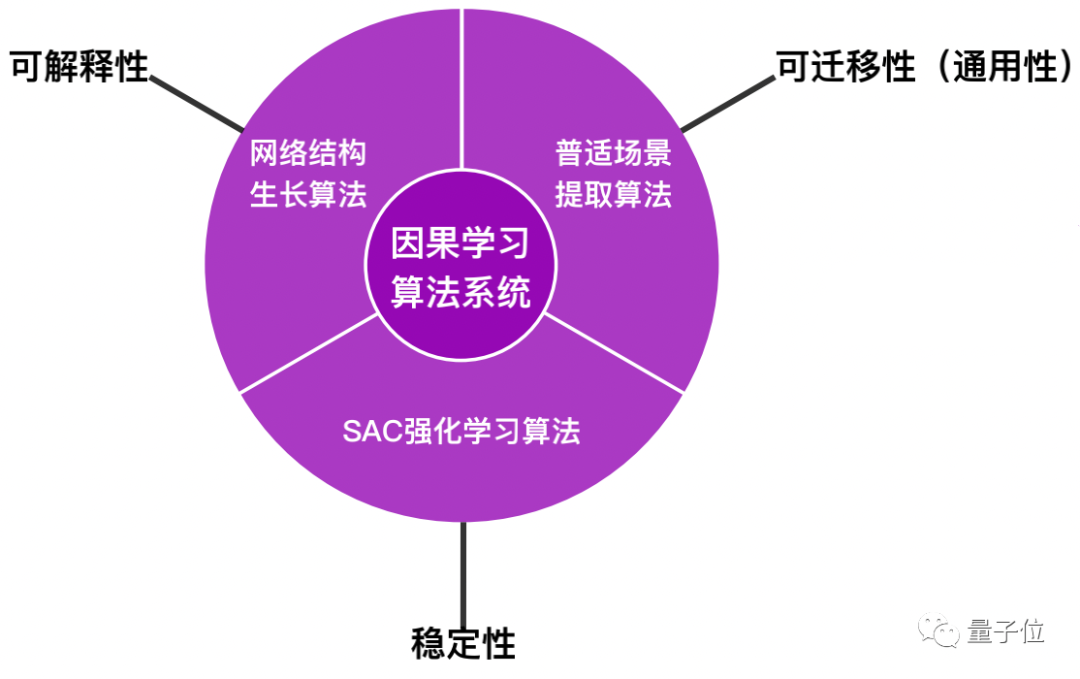

这家公司主要解决的是深度学习中的不可解释性问题,自研了基于SNN的可解释因果学习算法系统(CLAS Causal Learning Algorithm System)。

该系统下的因果学习算法*的特点就是像人脑一样,在学习权值的调节过程中,会根据因果关系去决定权值该增加还是减少——

从而做到并非单纯地去模仿数据,而是去理解数据产生背后的具体过程是什么样的。

当然,最后还需要利用强化学习去加强每个因果过程(即前后神经元之间的连接关系)。

在此,杨旭博士解释道,通过模仿数据找规律的方式就是现在ANN的工作方式,这种网络对数据样本质量的要求非常高,而后者,在SNN上采取因果学习的方法,就没有这种要求了,甚至可能只需小样本就可以做到智能通用。

“就像人类认猫认狗,我们只需要认识路边的几只就知道狗长什么样,不需要把全世界的都看一遍。”

对于因果学习的合理性,何虎教授则表示,我们这个世界本身就是一套因果系统,人类文明可以说就是靠着不断去问为什么而往前发展的。就像学生,要真正学会解一道数学题,靠不求甚解地背过程是不可能的,还是需要知道每一步都是如何推理出来,即每一步的因果关系。

那么因果学习系统能带来的*好处是什么呢?

是决策,何虎教授表示。

而优智创芯开发的这套因果学习算法一开始就瞄准的正是深度学习中的非*信息决策问题(以自动驾驶为例,可能会出现的非*信息就包括物体遮挡,道路交通标志不完整、不准确等情况)。

因此,针对该类问题的经典场景之一——打扑克,该公司实现了*基于SNN的斗地主AI——“智玩”。

最终,“智玩”通过了107个人类个体样本不严谨图灵测试,拟人化程度超过80%,再经过人类个体样本训练,个性化程度达到了85%,胜率*做到了49%,实现了“像人一样玩游戏”的目标。

除了“智玩”机器人,优智创芯还利用其自研的CLAS因果学习算法系统设计了类脑芯片。

其中,旗舰类脑芯片“思辨1号”对标SpiNNaker,采用28nm工艺,主频为2 GHz,支持RISC-V Vector 1.0指令集,同时支持AI加速(算力可达4TOPS)和类脑计算(SNN因果学习算法),单芯片同时*可实现100万个神经元运算的同时,功耗不高于2W,性能可以与英特尔Loihi2媲美。

除此之外,优智创芯还构建出了基于CLAS因果学习算法系统和类脑芯片组成的整体解方案——“硅脑”全自主无人系统平台。

基于功耗小、成本低、具有可解释性以及可以自主灵活决策的特点,该平台聚焦在无人机、无人驾驶、机器人的应用,可以扩展到AIGC、元宇宙、脑科学研究等领域。

由该平台衍生出来的K50/K51型SFS全自主无人飞行系统(类脑计算盒子)直接挂载在无人机上即能够实现未知地域且离线状态下的全自主飞行任务,可以用于电力巡线、海岸、植被、轨道交通、矿山、消防等多场景全自主无人飞行巡查,也可用于军事领域的武器突防等。

以及衍生出来的C60型SDS全自主无人驾驶系统(类脑计算盒子),正在与多家车企合作验证,相信不久的将来,就会出现正真意义上的L4+级别无人驾驶汽车在城市中自由穿梭。

03

市场规模将达200亿美元

综上,我们可以看到,类脑计算并非“束之高阁”,而是已经走出实验室,开始了商业化的摸索。

据Yole Development预测,2035年类脑计算市场将占人工智能总收入的15%-20%,市场规模将达到 200亿美元。

虽然目前领域还处于发展的早期,面临着诸多待解难题,但已经显现出了势不可挡的趋势。我们认为理由有三。

首先,纵观人工智能发展的历史,从ANN到DNN,其实都是基于对大脑的模仿。

比如2016年击败围棋世界冠军李世石的AlphaGo,作为一个深度学习神经网络,它所利用的多层训练法就借鉴了一项认知科学的研究结果:

人们认识事物并不是通过直接分析,而是依靠一种逐层抽象的认知机制,即首先学习简单的概念,然后用它们去表示更抽象的。

当然,诸如AlphaGo此类DNN都还是对大脑功能相对简单和抽象的模仿,存在着各种局限性。

第三代神经网络SNN由此诞生,除了神经元和突触状态之外,SNN还将时间概念纳入其中,实现了更*的大脑生物神经模拟水平,有望打破现有的神经网络在功耗、算力、样本数量和质量等方面的限制。

因此,我们说,类脑计算不失一种顺势而为的科技发展趋势。

其次,要从当下最火热的通用人工智能(AGI)说起。

毫无疑问,现阶段的一些AI技术已经可以在某些特定任务上打败人类,但没法在所有技能上胜出。

这就像北京师范大学认知神经科学和学习国家重点实验室研究员万小红博士等所说,人工智能更专业,自然智能更通用。

更通用的强人工智能是AI发展的*目标。就在一个多月之前,图灵奖得主LeCun公布的未来十年研究计划,就将AGI作为核心目标。

由于人类智能的核心是大脑,模拟大脑的类脑计算也就成为了实现AGI的一大重要路径。

最后,再将目光聚焦到当下,可以说,我们从未像今天这样需要新型计算机。

调查显示,全球每三四个月对于算力的需求就会翻一倍,这个增长速度已经远超摩尔定律和Dennard缩放定律。

但传统冯·诺伊曼计算架构存算分立的设计,让处理器即使再快也要等内存,算力根本无法得到提高。

作为新型计算形态的一种,类脑计算芯片有望打破这一僵局。

此外,值得一提的是,虽说目前人类对大脑的研究还远不够透彻,但北京理工大学杨旭博士和北京师范大学万小红博士——两位一个来自计算机科学领域,一个来自认知神经科学,都一致认为:

这并不会真正妨碍类脑计算向前发展。

相反,他们都表示,AI技术的发展反过来还可以促进脑科学的研究,两者其实是相互成就的关系。

那么,等到真正的类脑时代来临之时,它将会和传统的人工智能技术并存,还是完全取代后者?又将会给人类社会带来怎样的变革?

这无疑充满了想象的空间。我们拭目以待。

参考文献:[1]https://news.sciencenet.cn/htmlnews/2022/1/472375.shtm

[2]https://www.sohu.com/a/424817554_129720

[3]https://www.sgpjbg.com/info/25374.html

[4]https://www.ahpst.net.cn/News/show/18405.html

[5]https://s3.i-micronews.com/uploads/2021/05/YINTR21214-Neuromorphic-Computing-and-Sensing-2021-Flyer.pdf

[6]张臣雄 .《AI芯片:前沿技术与创新未来》

行业资讯、企业动态、业界观点、峰会活动可发送邮件至news#citmt.cn(把#换成@)。

海报生成中...